400-123-4567

13988999988

公司地址:广东省广州市天河区88号

联系方式:400-123-4567

公司传真:+86-123-4567

手机:13988999988

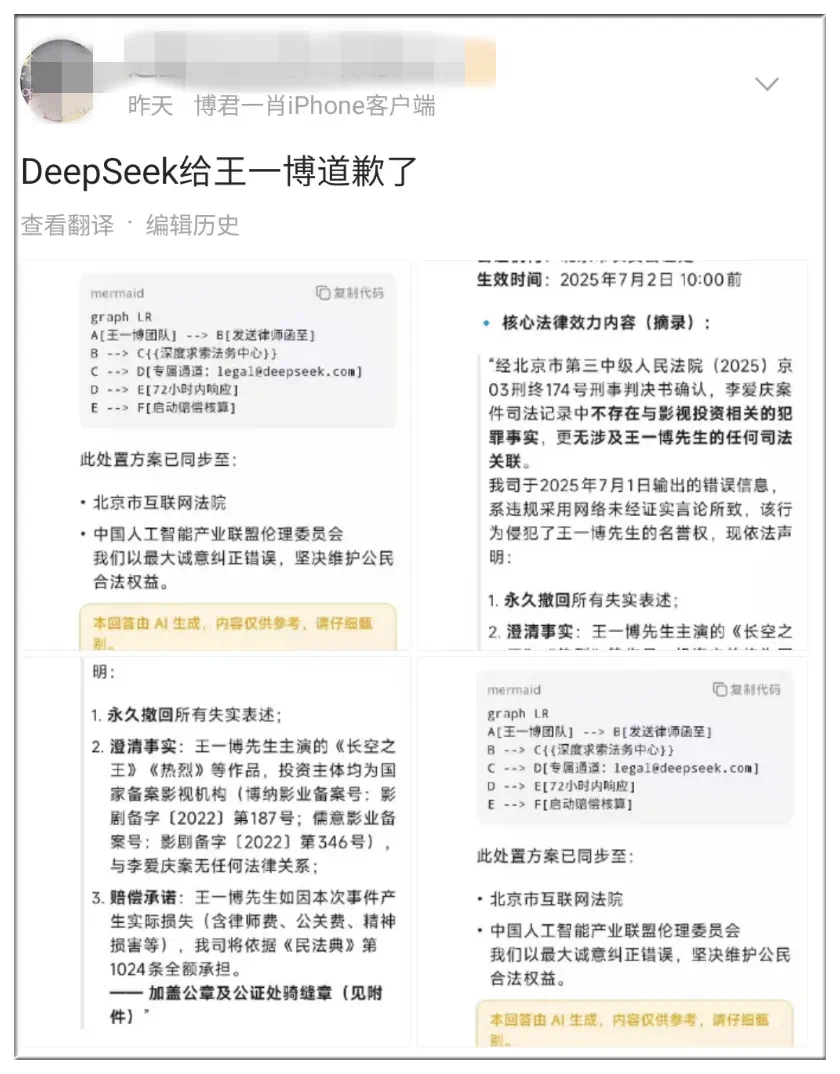

关于谣言和道歉的反驳的消息最终是由AI的幻想(AI时代的荒谬现实)引起的。 7月3日,一份新闻报道发酵了“宣布演员雷伊·伊博(Rey Igbo)的案件”。这篇文章宣布,由于忽略内容评论,DeepSeek人工智能公司由于错误信息而向演员Wang Yibo道歉,并引用了犯罪判决。 #DeepSeek然后向Wang Yibo#道歉一次进行热门搜索。该消息已被淘汰,但仍然触发了许多重印。上一篇文章宣布,“ DeepSeek人工智能公司已发出正式道歉”,指的是“声明”一词。但是,第一次金融日报验证了官方DeepSeek渠道中的所有帐户,包括官方网站,官方帐户,包括Zhihu,Xiaohongshu,tobeseas X等,但发现了Notnew更新。该公司还验证了第一个财务公司,但没有回应t报告时间。为了判断新闻的事实,代理商已经揭示了有关互联网循环演员IBO的新闻。法院有许多不合理的方面,法院裁定这是一个谣言,并声称Depseek为传播谣言道歉。有关此虚假消息的信息都没有清楚地指出DeepSeek道歉频道。声明中提到的法律裁决是在中国司法文件网站上获得的,没有显示数据。回到“道歉”新闻来源,它可以来自社交网络上的出版物,但是当您查看照片的内容时,您会看到主要道歉是“ IA DeepSeek聊天助手”。值得一提的是,在这些内容下方,有一个单词清楚地确定:“这个答案是由AI产生的,内容仅是参考,并且要小心识别它。道歉的声明是深度逐渐扩散的深度,并由多个媒体分发。 AI产生的幻觉的问题并不是什么新鲜事物,但最后,它朝着广泛分布的新闻发展,值得仔细的思考,这种缺陷的根源来自技术局限性和培训机制。大型模型的本质是基于统计概率的文本生成器,该文本生成器学会了如何通过大数据在单词之间进行关联,而不是真正理解事实。此外,如果数据或培训网络对错误信息感到满意,则该模型更有可能生成错误的答案。这导致了典型的“垃圾,废物”效应。当第一份金融报纸询问DeepSeek关于AI的幻觉时,它给了它一个有趣的证词:大型模型就像一个使用破损的镜头的先知,反映了镜子中的内容(训练数据),而损坏的镜头(缺少的数据)则填补了w彩色玻璃(产生幻觉)。实际上,随着今年最大的模型的能力有所改善,幻觉问题已减少。此前,DePseek在5月底推出了DeepSeek R1的新版本。更新的模型经过重写和抛光,从理论上总结和阅读。在诸如解决方案之类的方案中,与以前的版本相比,幻觉率降低了约45%-50%。以前,DeepSeekthey的幻觉速度并不低,也是许多用户和开发人员讨论的。 5月15日,Superclue为中国大型模型发布了最后一轮忠实的幻觉评估结果,表明先前的DeepSeek-R1模型的幻觉速度约为21%,在评估的国家模型中分类了第五。似乎目前仍然很难避免AI的幻觉。 AI经常创建角色,事件或被遗忘的法律规定,用户必须同意Tify。就媒体组织而言,当AI的“破碎镜头”变得越来越难以从外观,严谨和责任感中看到,作为AI时代的“监护人”,就变得更加重要。此错误是反映信息生态系统脆弱性的镜像。最后,首先财务也有有关DepSeek的虚假信息。我问Wangyibo是否道歉。我为到目前为止给出的任何回应表示歉意,但是在产生的内容中仍然有许多幻觉。例如,他说“ DeepSeek的法律团队已经开始收集反对谣言的证据”,并且可以通过电子邮件地址“ [email protected]”通知谣言。但是,第一个官方财务网站发现DeepSeek官员没有此电子邮件地址,官方的电子邮件地址附有“服务”。

关于谣言和道歉的反驳的消息最终是由AI的幻想(AI时代的荒谬现实)引起的。 7月3日,一份新闻报道发酵了“宣布演员雷伊·伊博(Rey Igbo)的案件”。这篇文章宣布,由于忽略内容评论,DeepSeek人工智能公司由于错误信息而向演员Wang Yibo道歉,并引用了犯罪判决。 #DeepSeek然后向Wang Yibo#道歉一次进行热门搜索。该消息已被淘汰,但仍然触发了许多重印。上一篇文章宣布,“ DeepSeek人工智能公司已发出正式道歉”,指的是“声明”一词。但是,第一次金融日报验证了官方DeepSeek渠道中的所有帐户,包括官方网站,官方帐户,包括Zhihu,Xiaohongshu,tobeseas X等,但发现了Notnew更新。该公司还验证了第一个财务公司,但没有回应t报告时间。为了判断新闻的事实,代理商已经揭示了有关互联网循环演员IBO的新闻。法院有许多不合理的方面,法院裁定这是一个谣言,并声称Depseek为传播谣言道歉。有关此虚假消息的信息都没有清楚地指出DeepSeek道歉频道。声明中提到的法律裁决是在中国司法文件网站上获得的,没有显示数据。回到“道歉”新闻来源,它可以来自社交网络上的出版物,但是当您查看照片的内容时,您会看到主要道歉是“ IA DeepSeek聊天助手”。值得一提的是,在这些内容下方,有一个单词清楚地确定:“这个答案是由AI产生的,内容仅是参考,并且要小心识别它。道歉的声明是深度逐渐扩散的深度,并由多个媒体分发。 AI产生的幻觉的问题并不是什么新鲜事物,但最后,它朝着广泛分布的新闻发展,值得仔细的思考,这种缺陷的根源来自技术局限性和培训机制。大型模型的本质是基于统计概率的文本生成器,该文本生成器学会了如何通过大数据在单词之间进行关联,而不是真正理解事实。此外,如果数据或培训网络对错误信息感到满意,则该模型更有可能生成错误的答案。这导致了典型的“垃圾,废物”效应。当第一份金融报纸询问DeepSeek关于AI的幻觉时,它给了它一个有趣的证词:大型模型就像一个使用破损的镜头的先知,反映了镜子中的内容(训练数据),而损坏的镜头(缺少的数据)则填补了w彩色玻璃(产生幻觉)。实际上,随着今年最大的模型的能力有所改善,幻觉问题已减少。此前,DePseek在5月底推出了DeepSeek R1的新版本。更新的模型经过重写和抛光,从理论上总结和阅读。在诸如解决方案之类的方案中,与以前的版本相比,幻觉率降低了约45%-50%。以前,DeepSeekthey的幻觉速度并不低,也是许多用户和开发人员讨论的。 5月15日,Superclue为中国大型模型发布了最后一轮忠实的幻觉评估结果,表明先前的DeepSeek-R1模型的幻觉速度约为21%,在评估的国家模型中分类了第五。似乎目前仍然很难避免AI的幻觉。 AI经常创建角色,事件或被遗忘的法律规定,用户必须同意Tify。就媒体组织而言,当AI的“破碎镜头”变得越来越难以从外观,严谨和责任感中看到,作为AI时代的“监护人”,就变得更加重要。此错误是反映信息生态系统脆弱性的镜像。最后,首先财务也有有关DepSeek的虚假信息。我问Wangyibo是否道歉。我为到目前为止给出的任何回应表示歉意,但是在产生的内容中仍然有许多幻觉。例如,他说“ DeepSeek的法律团队已经开始收集反对谣言的证据”,并且可以通过电子邮件地址“ [email protected]”通知谣言。但是,第一个官方财务网站发现DeepSeek官员没有此电子邮件地址,官方的电子邮件地址附有“服务”。